画像やテキストから3Dの点群データやメッシュデータを作成できるAIモデルがOpenAIからリリースされているので、試してみた。

Point-Eについて

Point-Eは、OpenAIから昨年発表された3Dオブジェクトを生成するAIで、ソースコードもGithubで公開されている。

https://github.com/openai/point-e

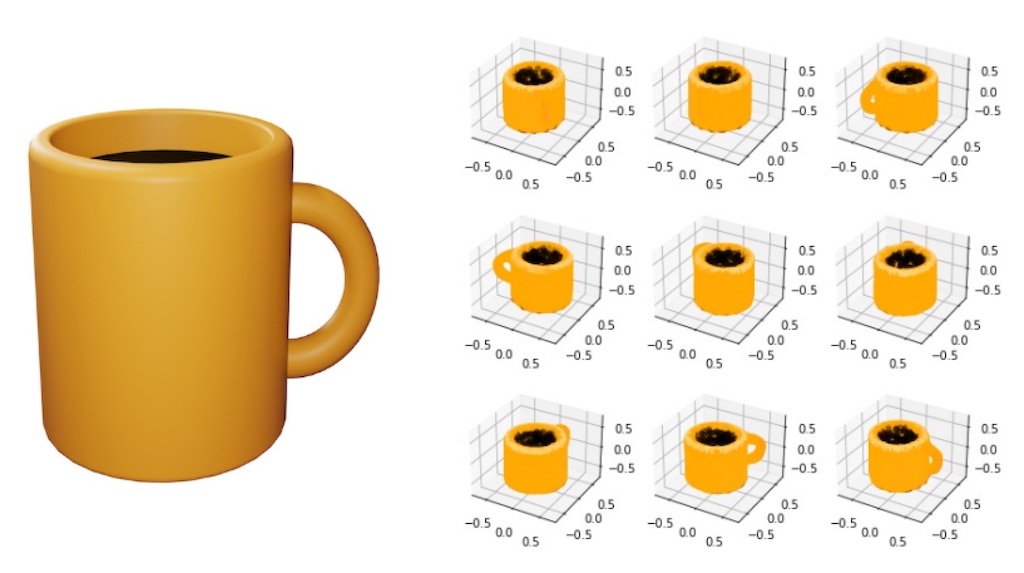

以下の画像のように3Dオブジェクトを高速で生成してくれる。(以下は元論文からの画像)

画像からポイントデータの生成

環境はGithubに公開されているimage2pointcloud.ipynbをそのまま利用。イラストはフリーのマグカップの画像を使用した。左が入力画像で、右が出力画像。このように色々なアングルからの画像を出力してくれる。

生成された点群データが以下の動画になる。取っ手の位置など微妙なところがある。Githubのコメントを見ると精度を向上させる方法がないかという質問も多く、まだまだ改善の余地がありそう。

テキストから点群データの生成

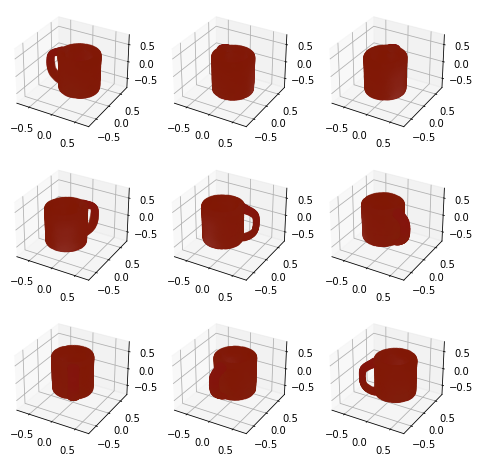

今度はテキストを入力して、点群データを作成してみる。環境は同じくGithubに公開されているtext2pointcloud.ipynbを利用。”A brown mug with coffee” を入力。先ほどの画像から生成するよりもずっときれいなデータになっている。ただ、テキストで難しいのは、自分の欲しい画像を得るまでにどのようにテキスト入力をするかがポイントとなる。マグカップと入れても取っ手がなかったり、以下も色が自分の思っているより濃い目なので、期待通り出そうとするのは中々難しい。

そしてこちらが最終的な点群データ。

このPoint-EはBlenderへのアドオンもリリースされているので、画像やテキストを入力し、そこから3Dの点群データとしてBlenderに取り込むことができるようになっている。ただ、綺麗な3Dモデルの生成はまだまだ改善が必要そうだ。